O mundo da inteligência artificial tem sido dominado até agora pelos modelos de linguagem de larga escala, ou LLM (Large Laanguage Model). São estes modelos que fazem funcionar o ChatGPT, o Bard e o Copilot. Agora, os principais concorrentes neste mercado estão a apostar também nos modelos de linguagem de pequena escala ou SLM (Small Language Model), que requerem menos recursos de computação e podem, por exemplo, ser integrados em dispositivos móveis. Depois do Gemini Nano da Google, a Microsoft apresentou ontem o Phi-2, um modelo de pequena escala integrado no Azure Ai Studio, que é capaz de entender linguagem e de algum raciocínio.

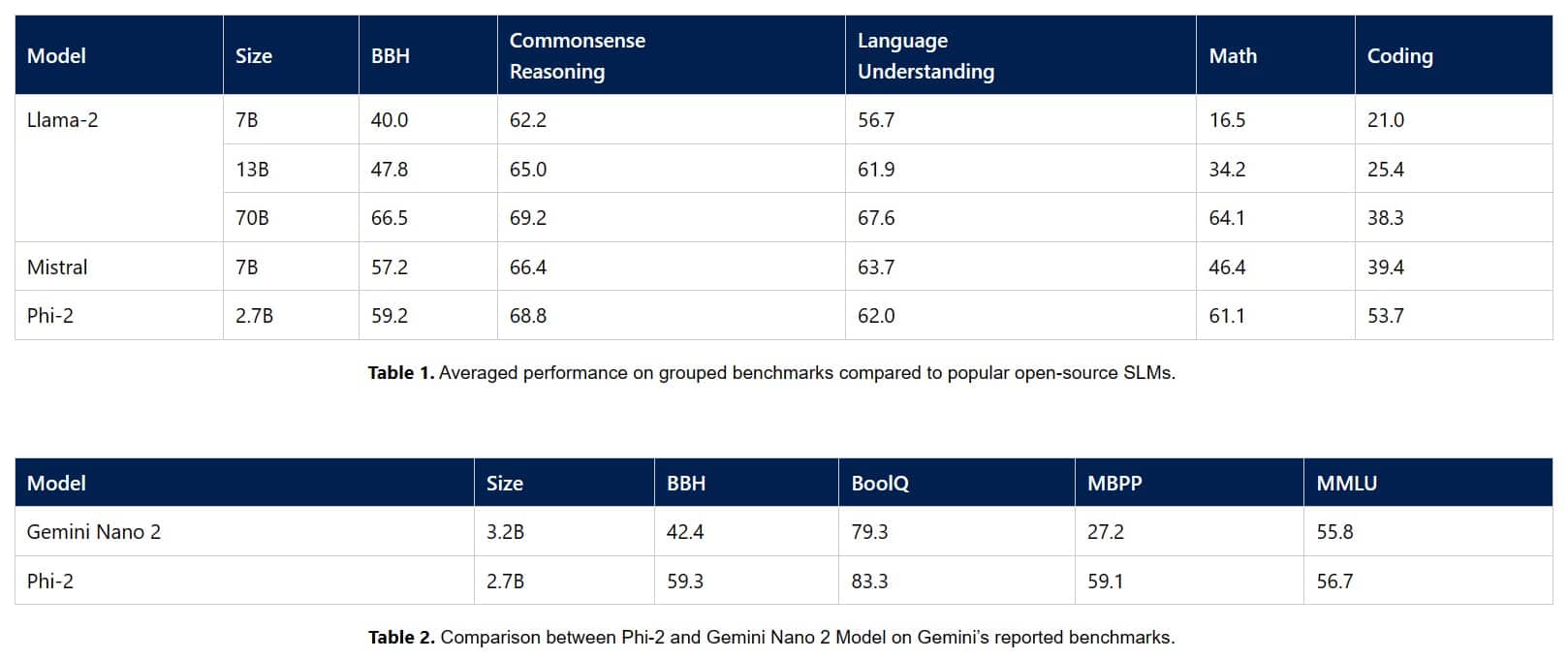

Apesar de ser considerado pequeno, o Phi-2 tem 2,7 mil milhões de parâmetros, uma diferença substancial para os 1,3 mil milhões do Phi-1.5. De acordo com a Microsoft, o Phi-2 consegue comparar-se a modelos mais poderosos e até ultrapassá-los em alguns benchmarks. Entre os modelos que foram ultrapassados pelo Phi-2 estão o Llama-2 da Meta, o Mistral e o Gemini nano da Google.

Para treinar o Phi-2, a Microsoft diz que usou apenas conteúdos de alta qualidade. A base de dados do modelo foi depois aumentada através da adição de dados seleccionados a partir da web, que forma filtrados de acordo com o seu valor educacional e qualidade do conteúdo.

Os SLM são alternativas aos LLM e podem ser usados em tarefas que não necessitem do conhecimento mais vasto proporcionado pelos LLM. Por outro lado, o poder de cálculo necessário para os fazer funcionar é muito mais reduzido, o que quer dizer que não há necessidade de investir em GPU especializados para garantir o seu processamento.