Ao contrário do esperado, não foram revelados novos modelos de placas gráficas GeForce RTX da série 40 durante o Nvidia GTC (GPU Technology Conference), mas o gigante de Santa Clara aproveitou a ocasião para revelar algo ainda mais revolucionário, o novo GPU Hopper H100 NVL, que foi criado específicamente para lidar com os novos desafios da Inteligência Artificial.

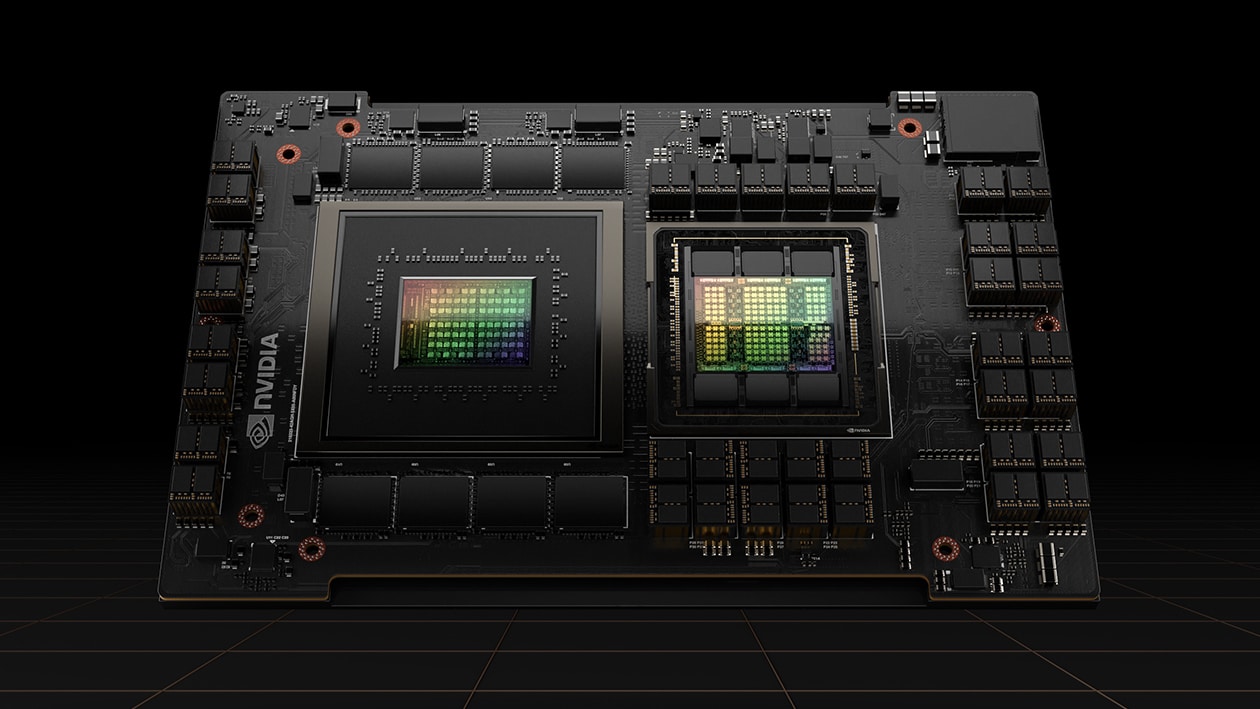

No fundo trata-se de um GPU Hopper H100, já revelado anteriormente na sua variante H100 SXM, ou seja, em forma de módulo que pode ser instalado em qualquer tipo de servidor. Este GPU tem um total de 16896 núcleos CUDA, 528 núcleos Tensor, e todos eles funcionam a uma frequência de 1.98 GHz, precisamente as mesmas características que a variante original H100 SXM, ao contrário da variante PCI-Express, que foi obrigada a reduzir diversos parâmetros.

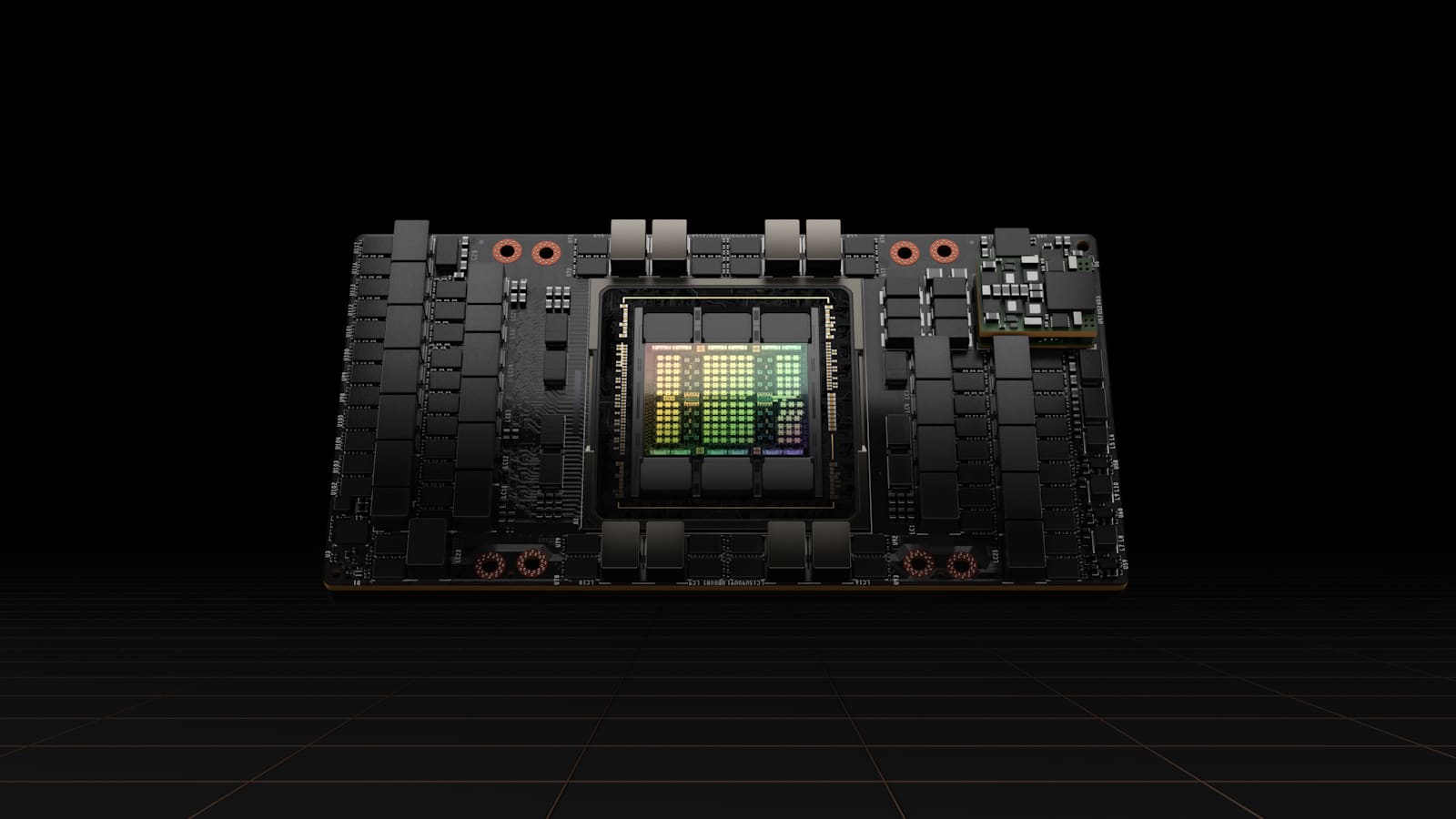

Com a chegada desta variante H100 NVL, tem a particularidade de utilizar dois GPU numa só placa, duplicando assim todas as características técnicas que revelámos anteriormente, esta será aproveitada para a criação de servidores específicos para tarefas LLM (Large Language Models), o que corresponde a aplicações como aprendizagem de modelos, como fazem os servidores que alimentam ferramentas como o ChatGPT.

Assim sendo, cada módulo incluirá dois dos GPU H100 com todas os módulos activos, ou seja, os seis módulos de memória HBM3 integrado no próprio GPU com uma capacidade de 96 GB por GPU, ou seja, um total de 188 GB por módulo, um incremento face aos 80 GB disponíveis no GPU utilizado tanto no módulo SXM como na variante PCIe. Esta comunica com o GPU através de um barramento de 6144-bit, o que corresponde a uma dupla largura de banda de 3.9 TB/s.

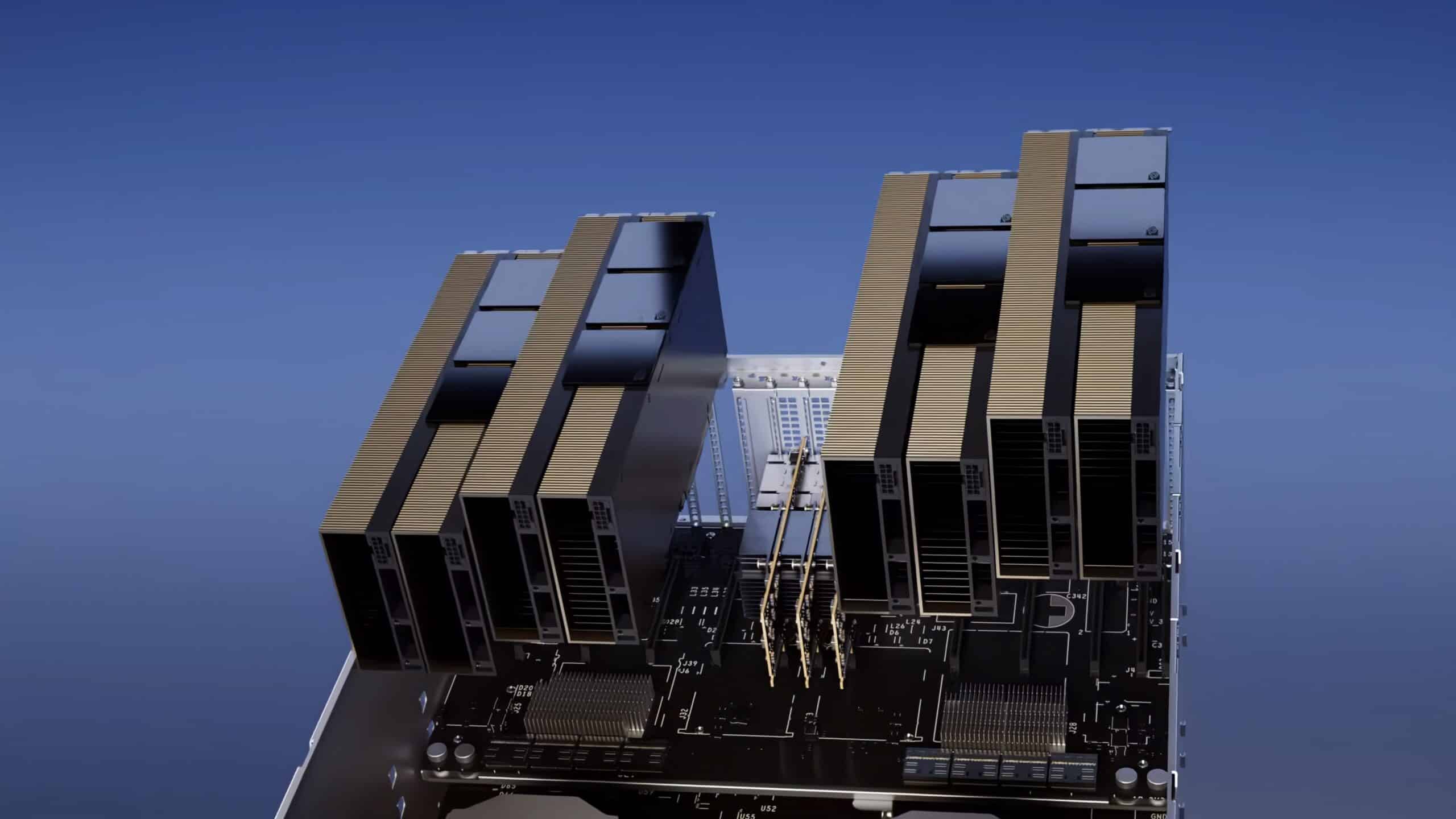

Segundo a Nvidia, cada módulo destes deverá ser capazes de processar 175 mil milhões de parâmetros ChatGPT em simultâneo, o que significa que um servidor novo equipado com quatro GPU H100 NVL será capaz de oferecer um desempenho até 10 vezes superior ao de um tradicional servidor DGX A100 equipado com oito GPU da anterior geração GA100 Ampere.

| Nvidia H100 NVL | Nvidia H100 PCIe | Nvidia H100 SMX | Nvidia A100 PCI | Nvidia A100 SXM | |

| GPU | 2x GH100 | GH100 | GH100 | GA100 | GA100 |

| Processo de fabrico | 4 nm | 4 nm | 4 nm | 7 nm | 7 nm |

| Transístores | 80 mil milhões | 80 mil milhões | 80 mil milhões | 54.2 mil milhões | 54.2 mil milhões |

| Dimensão GPU | 814 mm2 | 814 mm2 | 814 mm2 | 815 mm2 | 815 mm2 |

| Núcleos CUDA | 2x 16896 | 14592 | 16896 | 6912 | 6912 |

| Núcleos Tensor | 2x 528 | 456 | 528 | 432 | 432 |

| Memória | 2x 94 GB HBM3 | 80 GB HBM2e | 80 GB HBM3 | 80 GB HBM2e | 80 GB HBM2e |

| Barramento | 6144-bit | 5120-bit | 5120-bit | 6144-bit | 6144-bit |

| Largura de banda | 2x 3.9 TB/s | 2.0 TB/s | 3.35 TB/s | 1.9 TB/s | 2.0 TB/s |